ChatGPTをはじめとした生成AIが話題になっています。メディアではよく取り上げられる言葉なので、聞いたことがある方も多いのではないでしょうか。

生成AIの1つに画像生成AIがあり、その中の代表的サービスがStable Diffusion 2.0です。今回の記事では生成AIの概要やStable Diffusion 2.0のインストール方法をご紹介します。本記事を読むことで、よりStable Diffusion 2.0に関する知見が深まりますので、ぜひ参考にしてください。

生成AIとは?

生成AI(ジェネレーティブAI)は、ディープラーニング(深層学習)や機械学習の手法を駆使して、テキスト、画像、音楽、ビデオなどを自動で生成する技術です。ディープラーニングは、機械学習の一種であり、大量のデータをもとに自動で特徴量を抽出し、学習していくAI技術です。

生成AIの技術は大量のデータからパターンを学習し、それをもとに新しい、オリジナルのコンテンツを創出する能力を持ちます。

生成AIは、既存のデータをコピーするのではなく、学習したデータをもとにして新しい創作物を生み出すことで、クリエイティブな分野だけでなく、ニュース記事の作成、広告の制作など、幅広い応用が期待されています。

AIについて知りたい方は以下の記事を参考にしてください。

Stable Diffusionとは?

テキストから画像を生成するAIがStable Diffusion 2.0です。この技術は、深層学習と機械学習の手法を駆使して、テキスト入力に応じて高品質で写真のような画像を生成します。例えば「サングラスをかけた猫」と入力すると、そのような画像が生成されます。

さまざまなスタイルの画像を生成でき、イラストや写真、水彩画、アニメ調など、自分の好みに合わせてAIに画像を生成してもらうことができます。

生成AI(ジェネレーティブAI)について詳しく知りたい場合は以下の記事を読んでみてください。

Stable Diffusion 2.0と1.5との違い

Stable Diffusion 1.5とStable Diffusion 2.0の違いを、解像度、ネガティブプロンプト、安定性の観点からまとめます。

解像度の向上

画像の解像度が従来の512 x 512から768 x 768に上がりました。これにより、より解像度が高い画像を生成できるようになりました。ただし、この解像度向上に伴い、使用メモリ量も増加しています。

ネガティブプロンプトの実装

「ネガティブプロンプト」とは、描いて欲しくない物を指定できる機能です。Stable Diffusion 2.0から導入されました。望ましくない要素を排除した画像生成ができるようになりました。

このネガティブプロンプトは、生成される画像から避けたい要素を指示するもので、例えば指や手の不整合、焦点が合っていない場合などが該当します。

ネガティブプロンプトをプロンプトに追記する際には、以下のように記述します:

|<negative prompt>: -1.0

ネガティブプロンプトは、画像生成のクオリティを向上させるために重要な要素です。以下はおすすめのネガティブプロンプトの一部です。

| ネガティブプロンプト | 内容 |

| worst quality | 最低品質、最悪の品質 |

| low quality | 低い品質 |

| out of focus/blurry/bokeh | ぼやける、ピンボケ、ピントが合わない |

| ugly | ひどい、醜い |

| bad anatomy | おかしい人体構造、変な身体 |

| jpeg artifacts | 圧縮による歪み |

| missing limb | 手や足の欠損 |

| bad hands | おかしい手や指、変な手や指 |

| missing fingers | 指の欠損 |

| extra digit | 指が多い |

これらのネガティブプロンプトを適切に組み合わせることで、クオリティの高い画像生成を実現できます。画像生成においては、ネガティブプロンプトを適切に活用して、理想的な結果を得ることをお勧めします。

安定性の向上

安定性が増していると感じられるStable Diffusion 2.0ですが、傾向が似た画一的な画像が多く生成されることもあります。一方、1.X系列は生成する画像にムラがありますが、多様性があり、面白い画像ができることもあります。

Stable Diffusion 1.5では全体的な品質が向上しており、歪みが少なく、リアルさが増しています。人物画像の生成には苦労していましたが、Stable Diffusion 2.0ではこの点が改善され、印象的な品質で異常が少ない出力を生成しています。

Stable Diffusion 2.0のローカルインストール方法

Stable Diffusion 2.0をパソコンにインストールする方法についてご紹介します。

インストールの事前準備

ローカル環境にStable Diffusion 2.0をインストールする前に、以下の事前準備を整えておきましょう。

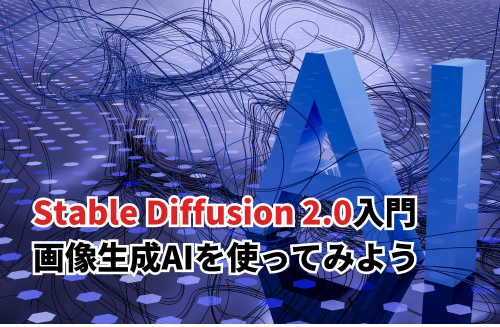

- Pythonのインストール

Stable Diffusion 2.0はPython上で動作します。バージョン3.10.6をインストールしておく必要があります。パスを追加することも忘れずに行いましょう。

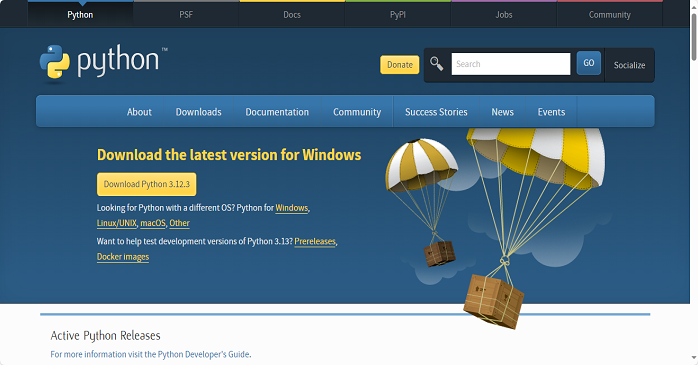

- Gitのインストール

Gitをインストールします。Gitはソースコードの管理やダウンロードに必要です。Gitは、プログラムのソースコードなどの変更履歴を記録・追跡するための分散型バージョン管理システムです。

インストール手順

ローカル環境にインストールするための手順です。

Stable Diffusion Web UIは、グラフィカルなインターフェースでStable Diffusion 2.0を操作できるツールです。インストール方法はいくつかありますが、以下の2つを試してみましょう。

1. Automatic1111

Stable Diffusion 2.0向けに開発されたWeb UIで、拡張機能が豊富です。このツールを使用することで、プログラミングの知識がほとんど必要なく、テキストから高品質な画像を簡単に生成できます。

以下はAutomatic1111の特徴です。

- Image-to-Image (画像から画像生成)

マスキング、トリミング、インペインティング、アウトペインティング、バリエーションが利用可能 - 様々なモデル

GFPGAN、RealESRGAN、LDSR、CodeFormerが利用できる - 高速な画像生成を実現

Stable Diffusion 2.0のローカル版であり、高速な画像生成を実現しており、バージョンによってはVRAMの節約や画像生成速度の向上が行われている

Automatic1111版とForge版の違いもありますが、どちらも便利なツールとして利用できます。

2. Forge

ForgeはStable Diffusion web UIをベースにした画像生成ツールで、以下の特徴があります。

- 画像生成処理が速い

Forgeは最適化されており、本家WebUIよりも高速に画像を生成できます。 - VRAMの使用量が少ない

Forgeは少ないVRAMでも効率的に画像生成できるため、非力なグラボでも快適に利用できます。 - ControlNetを使った場合の処理も速い

ControlNetを活用する際も高速に処理できます。

使い勝手は本家とほぼ同じ: 本家WebUIとほぼ同じインターフェースで、乗り換えが簡単です。

これらの準備を整えることで、Stable Diffusion 2.0をローカル環境で利用できるようになります。

モデルのダウンロード

Stable Diffusion 2.0には、解像度512のBaseモデルと解像度768のVモデルがあります。これらのモデルの違いを安定性の観点から見てみましょう:

1. Baseモデル (解像度512)

- デフォルトの解像度が512×512ピクセル

- このサイズはStable Diffusionの初期設定であり、多くのモデルがこのサイズで学習している

- 学習済みのモデルはこのサイズに慣れており、良質な画像を生成しやすい傾向がある

- 画像サイズが大きくなると、以下の問題が発生する可能性がある

指定したプロンプトで画像が生成できない。

画像ファイルのサイズが重くなる。

画像生成にかかる時間が長くなる。

2. Vモデル (解像度768)

- デフォルトの解像度が768×768ピクセル

- このモデルは従来の512×512ピクセルよりも大きな画像を生成できるようになった

- メモリ使用量が増加しており、一部の環境では生成枚数を減らす必要があるかもしれない

どちらのモデルを選択するかは、具体的な用途や環境によります。基本的には512×512ピクセルがおすすめですが、大きな画像を必要とする場合は768×768ピクセルを検討してください。

Stable Diffusion 2.0の活用方法

ビジネスにおいても、Stable Diffusion 2.0は活用できます。公式規約でも商用利用が認められているため、企業での利用も増えています。例えば、清涼飲料水メーカーの伊藤園は、CMにAIタレントを起用し、パッケージデザインにも画像生成AIを参考にしています。

商用利用する際には注意点もあります。著作権や肖像権を侵害しないように注意し、プロンプトの選定や指示の詳細にも注意を払いましょう。

Stable Diffusion 2.0は、クリエイティブな部分のクオリティアップや業務の効率化に貢献できるツールとして、今後ますます注目されることでしょう。

Stable Diffusionのように「人工知能システムを開発する側」として活躍したいと思う方もいるでしょう。そのような方はAI研究所が運営する「AIプロフェッショナル人材育成コース」がおすすめです。

この講座は短期集中の3日間でAIプログラミングのプロになるためのノウハウを学べる内容となっているため、最速てエンジニアを目指す方にうってつけでしょう。

受講形態も「会場受講」「ライブウェビナー」「eラーニング」から選ぶことができ、最安の「eラーニング」なら242,000円で受講可能。満足度も98.8%と高い水準を誇ります。

コスパ重視でAIセミナーを探している方は、ぜひご検討ください。

Stable Diffusion 2.0についてまとめ

Stable Diffusion 2.0を使うことで画像を自動的に生成することができます。1.0から2.0のバージョンの違いとしては、解像度向上、画質向上、ネガティブプロンプトの実装、安定性の向上があります。

より高解像度の画像を生成したい場合は、Stable Diffusion 2.0を使うのがよいでしょう。商用利用も可能なので、ビジネスにも活用できます。